本文详细介绍Transformers、ModelScope、vLLM、Llama.cpp、Ollama、TGI 这几种常用的大模型部署方式,包含具体的部署方法、适用情况以及优缺点分析,为大家做大模型部署技术选型提供依据。

1. Transformers

1.1 部署方法:

1.2 适用情况:

1.3 优缺点:

案例:

1、安装依赖

pip install transformers torch fastapi uvicorn

2、加载预训练模型和分词器

from transformers import BertForSequenceClassification, BertTokenizer

model_name = 'Qwen/Qwen3-8B'model = BertForSequenceClassification.from_pretrained(model_name)tokenizer = BertTokenizer.from_pretrained(model_name)

3、构建API服务

from fastapi import FastAPI, HTTPExceptionfrom pydantic import BaseModelimport torch

app = FastAPI()

class TextIn(BaseModel): text: str

@app.post("/predict")async def predict(text_in: TextIn):try:# 对输入文本进行编码 inputs = tokenizer(text_in.text, return_tensors="pt", padding=True, truncation=True, max_length=512)# 使用模型进行预测with torch.no_grad(): outputs = model(**inputs)# 获取预测结果 predictions = torch.nn.functional.softmax(outputs.logits, dim=-1) predicted_class = predictions.argmax().item()return {'predicted_class': predicted_class, 'probabilities': predictions.tolist()[0]}except Exception as e:raise HTTPException(status_code=500, detail=str(e))

4、运行运行API服务

uvicorn app:app --reload --host 0.0.0.0 --port 8000

2. ModelScope

2.1 部署方法:

2.2 适用情况:

2.3 优缺点:

3. vLLM

3.1 部署方法:

3.2 适用情况:

3.3 优缺点:

案例:

1、安装vLLM

pip install vllm

或者源码安装

git clone https://github.com/vllm-project/vllm.gitcd vllmpip install -e .

2、加载运行模型

从 Hugging Face 加载模型

vllm serve Qwen/Qwen2-7B-Instruct

加载本地模型

vllm serve /path/to/local/model

3、启动方式

单卡启动

vllm serve deepseek-ai/DeepSeek-V3-0324 --port 8000

多卡启动

vllm serve deepseek-ai/DeepSeek-V3-0324 --tensor-parallel-size 4

4. Llama.cpp

4.1 部署方法:

4.2 适用情况:

4.3 优缺点:

案例:

1、下载代码

git clone https://github.com/ggerganov/llama.cppcd llama.cpp

2、编译

cmake -B build -DGGML_CUDA=ON -DGGML_CUDA_ENABLE_UNIFIED_MEMORY=1cmake --build build --config Release -j 8

3、下载模型和格式转换

从 Hugging Face 或其他模型库下载所需的 LLM 模型,通常是以 .pth(PyTorch 格式)或 .safetensors 格式存在

转换为 GGUF 格式

python convert.py ./models/your-model-path --vocabtype spm

4、部署模型

./llama-server -m ./models/your-model-q8.gguf --port 8080

5. Ollama

5.1 部署方法:

5.2 适用情况:

5.3 优缺点:

案例:

安装ollama

curl -fsSL https://ollama.com/install.sh | sh

下载和运行模型

ollama run qwen3

6. TGI

6.1 部署方法:

6.2 适用情况:

6.3 优缺点:

案例:

1、安装TGI需要的环境

sudo apt-get install libssl-dev gcc -ycurl --proto '=https' --tlsv1.2 -sSf https://sh.rustup.rs | shPROTOC_ZIP=protoc-21.12-linux-x86_64.zipcurl -OL https://github.com/protocolbuffers/protobuf/releases/download/v21.12/$PROTOC_ZIPsudo unzip -o $PROTOC_ZIP -d /usr/local bin/protocsudo unzip -o $PROTOC_ZIP -d /usr/local 'include/*'rm -f $PROTOC_ZIP

2、克隆 TGI 仓库

git clone https://github.com/huggingface/text-generation-inference.gitcd text-generation-inference

3、编译和安装 TGI:

conda activate llm-plus # 激活一个虚拟环境(可选)BUILD_EXTENSIONS=True make install -j

4、下载和部署模型

从 Hugging Face 或其他模型库下载所需的大模型,确保模型格式与 TGI 兼容。

使用 TGI 提供的命令行工具启动模型服务

text-generation-launcher --model-id /path/to/your/model --trust-remote-code --port 4000

好的,以上就是这6种大模型的详细部署方式,你可以根据项目需求、硬件条件等因素进行选择。

感谢你们的阅读和喜欢,作为一位在一线互联网行业奋斗多年的老兵,我深知在这个瞬息万变的技术领域中,持续学习和进步的重要性。

为了帮助更多热爱技术、渴望成长的朋友,我特别整理了一份涵盖大模型领域的宝贵资料集。

这些资料不仅是我多年积累的心血结晶,也是我在行业一线实战经验的总结。

这些学习资料不仅深入浅出,而且非常实用,让大家系统而高效地掌握AI大模型的各个知识点。如果你愿意花时间沉下心来学习,相信它们一定能为你提供实质性的帮助。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

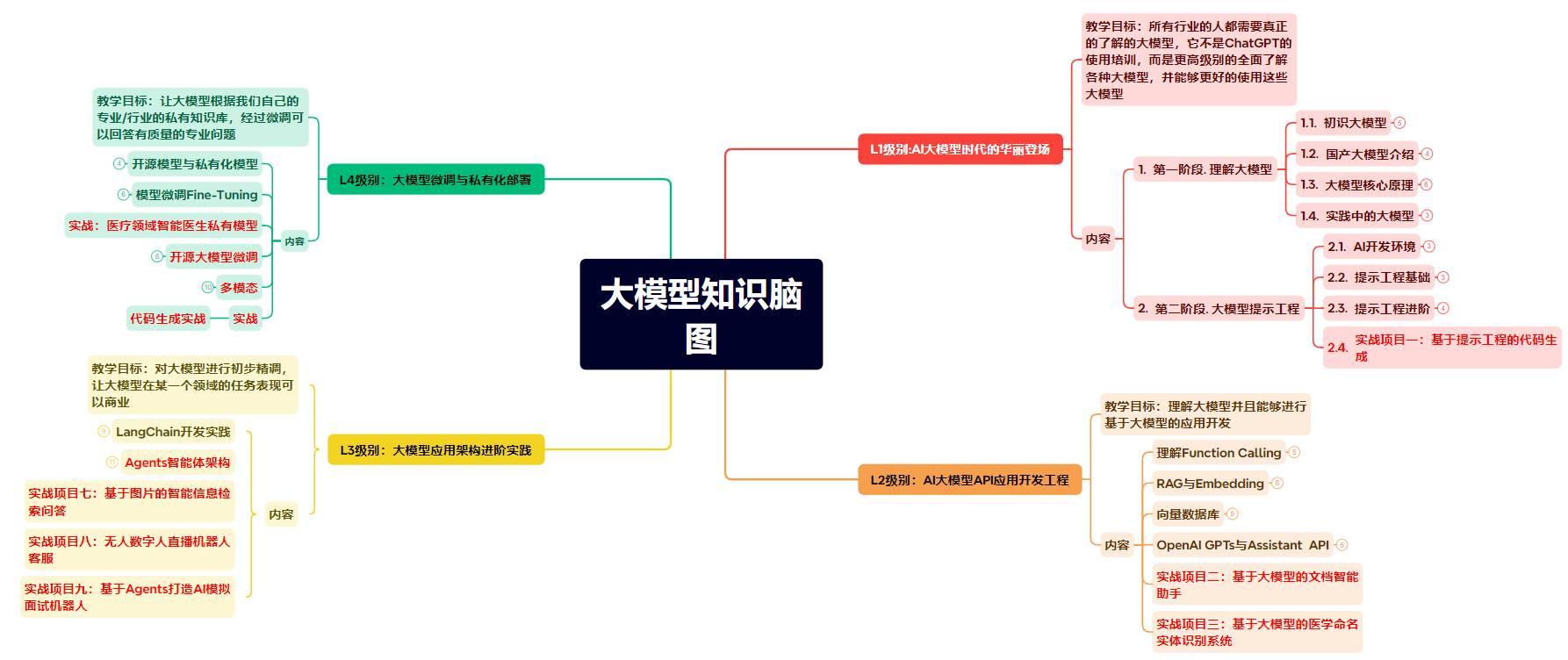

为了成为更好的 AI大模型 开发者,这里为大家提供了总的路线图。它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

阅读AI大模型经典书籍可以帮助读者提高技术水平,开拓视野,掌握核心技术,提高解决问题的能力,同时也可以借鉴他人的经验。对于想要深入学习AI大模型开发的读者来说,阅读经典书籍是非常有必要的。

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

我们学习AI大模型必然是想找到高薪的工作,下面这些面试题都是总结当前最新、最热、最高频的面试题,并且每道题都有详细的答案,面试前刷完这套面试题资料,小小offer,不在话下

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

版权说明:如非注明,本站文章均为 扬州驻场服务-网络设备调试-监控维修-南京泽同信息科技有限公司 原创,转载请注明出处和附带本文链接。

请在这里放置你的在线分享代码