通过本案例,让大家熟悉如何通过本地部署的DeepSeek搭建属于自己的Dify智能助手。

免费领取开发者空间云主机

pc端

移动端

DeepSeek是一家创新型科技公司,长久以来专注于开发先进的大语言模型(LLM)和相关技术。该公司推出了比较出名的模型有 DeepSeek-V3 和 DeekSeek-R1。

本案例通过在云主机部署DeepSeek搭建Dify智能体,进行智能助手的设定实现。与普通的对话系统不同,案例中通过提示词来设立Dify的角色和行为模式,Dify不仅仅是一个简单的问答工具,Dify 是一个生成式 AI 应用创新引擎,提供了健全的应用模板和编排框架,帮助开发者快速构建大型语言模型驱动的应用。它有两个版本:社区版和商业版,用户可以根据需求选择。Dify 还支持多个模型的接入,适用于不同的场景。此外,Dify 提供了完整的生产解决方案,经过精良的工程设计和软件测试,确保其可靠性。它运用智能化流程自动化与数据管理技术,帮助企业优化业务流程,提高工作效率。

本案例总时长预计60分钟。

说明:

① 云主机安装Ollama;

② 使用Ollama部署DeepSeek;

③ 云主机调用本地部署DeepSeek;

④ 下载Dfiy框架,创建Dfiy智能角色。

本案例预计花费总计0元。

| 资源名称 | 云主机 |

|---|---|

| 规格 | ARM 4vCPU 8GB |

| 操作系统 | Ubuntu 24.04 Server 定制版 |

| 单价 | 免费 |

| 时长 | 180小时 |

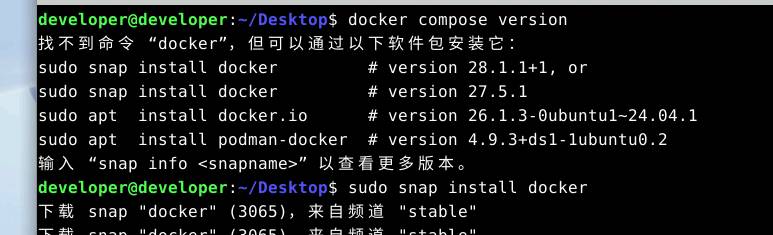

1安装docker

sudo snap install docker

2.docker compose version 命令检查版本

sudo docker compose version

Ollama 是一个强大的开源工具,旨在帮助用户轻松地在本地运行、部署和管理大型语言模型(LLMs)。它提供了一个简单的命令行界面,使用户能够快速下载、运行和与各种预训练的语言模型进行交互。Ollama 支持多种模型架构,并且特别适合那些希望在本地环境中使用 LLMs 的开发者和研究人员。

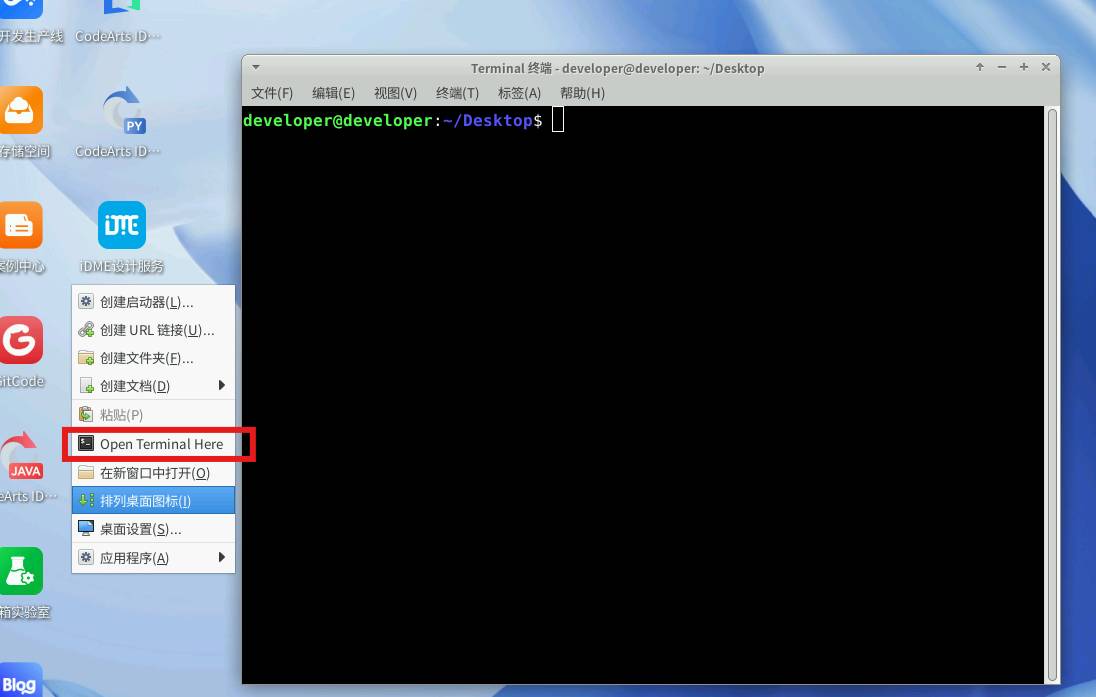

在云主机桌面右键选择“Open Terminal Here”,打开命令终端窗口。

执行安装命令如下:

方式一(官方安装链接时间较慢)本地执行

curl -fsSL https://ollama.com/install.sh | sh

docker pull swr.cn-north-4.myhuaweicloud.com/ddn-k8s/docker.io/ollama/ollama:latest-linuxarm64

docker tag swr.cn-north-4.myhuaweicloud.com/ddn-k8s/docker.io/ollama/ollama:latest-linuxarm64 docker.io/ollama/ollama:latest

方法一

克隆 Dify 代码仓库

克隆 Dify 源代码至本地环境。

当前版本为 0.15.3

git clone https://github.com/langgenius/dify.git --branch 0.15.3

方法二(推荐使用)通过百度云盘下载后上传到我的云空间

通过网盘分享的知识:Dify

链接: https://pan.baidu.com/s/5mjetRwc6gMTZgcRTBXHu8A

上传我的云空间

进入云服务机器从云空间下载文件包

1.进入目录

cd dify/docker

2.重命名文件,并启动docker服务

#重命名

sudo mv .env.example .env

sudo mv middleware.env.example middleware.env

#启动服务并查看docker服务

sudo systemctl start docker

sudo systemctl status docker

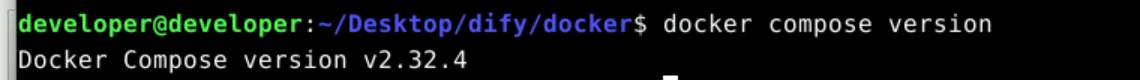

1.根据你系统上的 Docker Compose 版本,选择合适的命令来启动容器。你可以通过 docker compose version 命令检查版本

docker compose version

2.如果版本是 Docker Compose V2,使用以下命令:

sudo docker compose up -d

3.如果版本是 Docker Compose V1,使用以下命令:

sudo docker-compose up -d

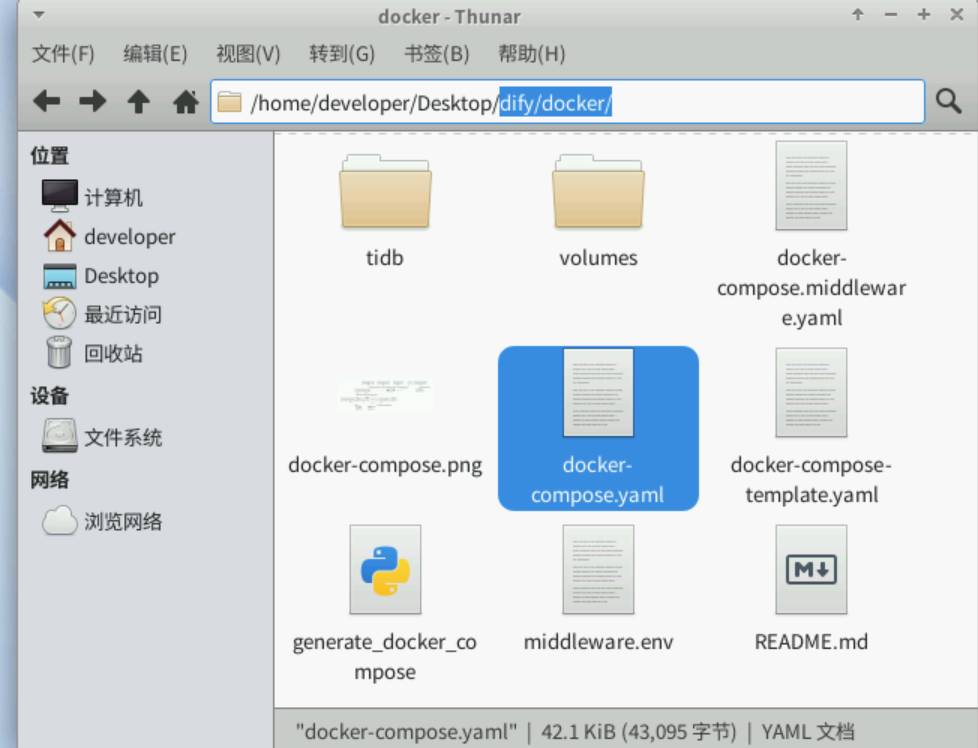

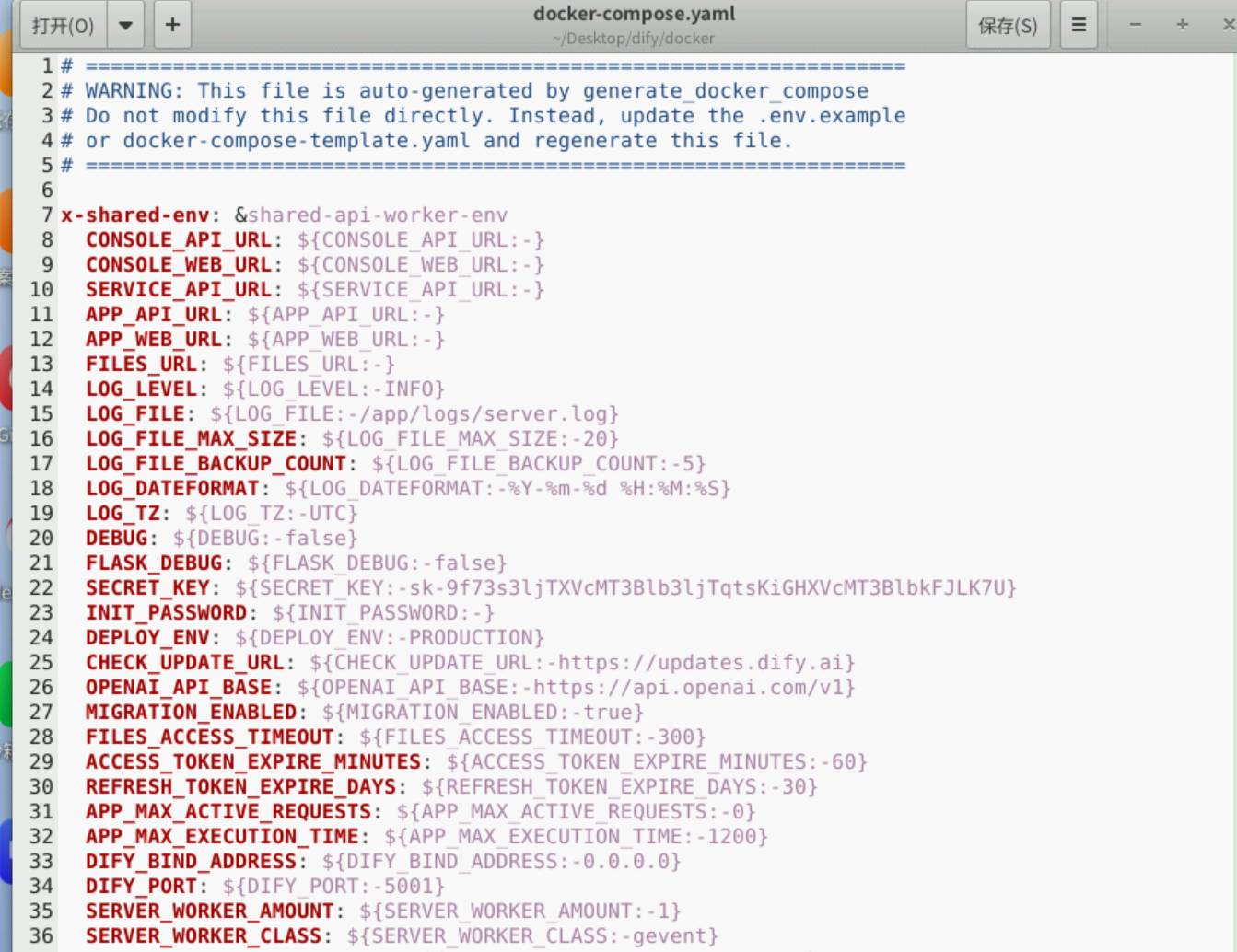

4.替换dify/docker/docker-compose.yaml文件(如果安装官网的执行docker-compose up -d 是会出现因为没有FQ很多组件无法正常下载的情况)

5.打开此文件全选删除里面的内容并复制或者删除源文件替换本文件

6.替换完执行执行相对应代码更新结束即完成

我的版本是V2

sudo docker compose up -d

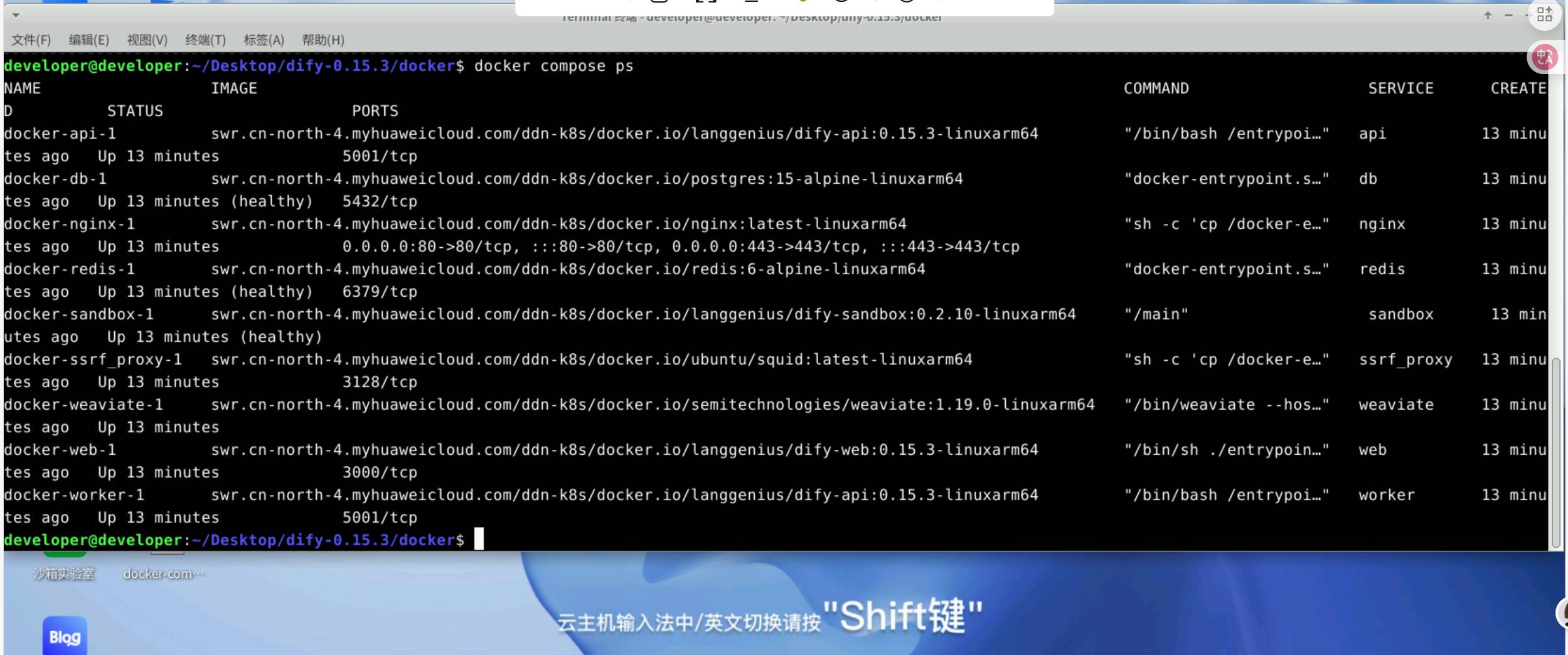

docker compose ps

1.在这个输出中,你应该可以看到包括 3 个业务服务 api / worker / web,以及 6 个基础组件 weaviate / db / redis / nginx / ssrf_proxy / sandbox 。

2.通过这些步骤,你可以在本地成功安装 Dify。

访问 Dify第一次启动较慢等待一段时间刷新一次就可以正常访问了

你可以先前往管理员初始化页面设置设置管理员账户:

本地环境

http://localhost/install

服务器环境

http://your_server_ip/install

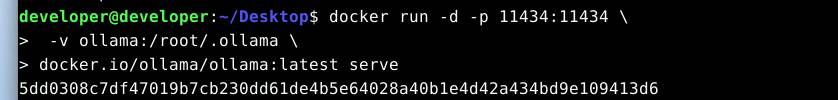

启动 Ollama 容器

要启动 ollama 容器,需要运行以下命令:

docker run -d -p 11434:11434 \

-v ollama:/root/.ollama \

docker.io/ollama/ollama:latest serve

这个命令会启动一个后台运行的容器,将容器内的 11434 端口映射到主机的 11434 端口,并创建一个名为ollama的卷来持久化存储模型。

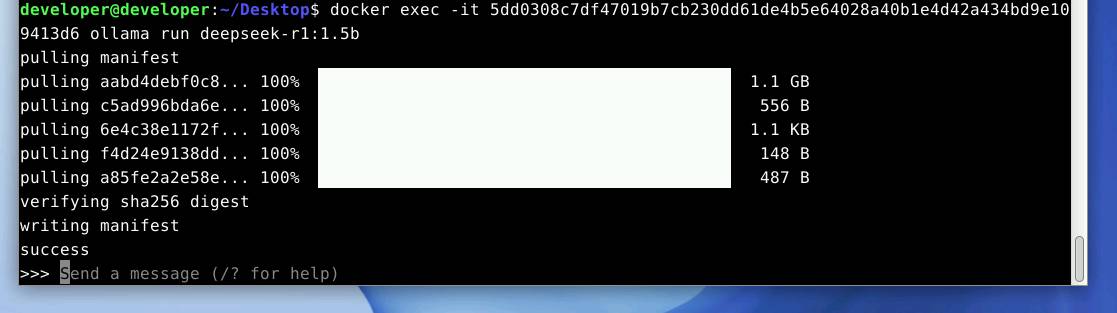

方法1:通过docker exec命令在容器内运行ollama pull

docker exec -it <container_id> ollama pull llama2

docker exec -it 5dd0308c7df47019b7cb230dd61de4b5e64028a40b1e4d42a434bd9e109413d6 ollama run deepseek-r1:1.5b

#简化id前三个 3-4个字符

docker exec -it 5dd0 ollama run deepseek-r1:1.5b

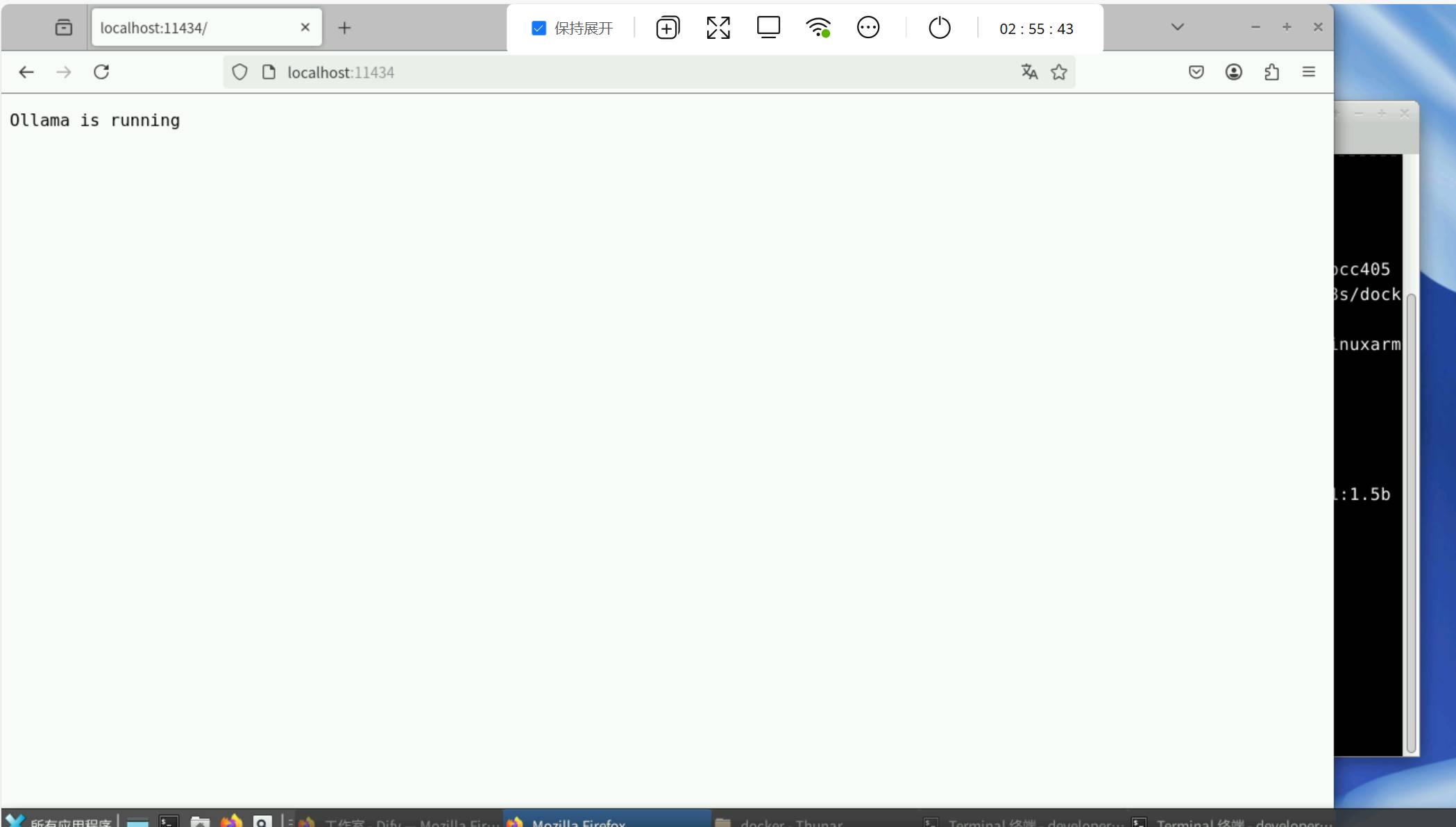

启动成功后,ollama 在本地 11434 端口启动了一个 API 服务,可通过 http://localhost:11434 访问。

如需运行其它模型,访问 Ollama Models 了解详情。

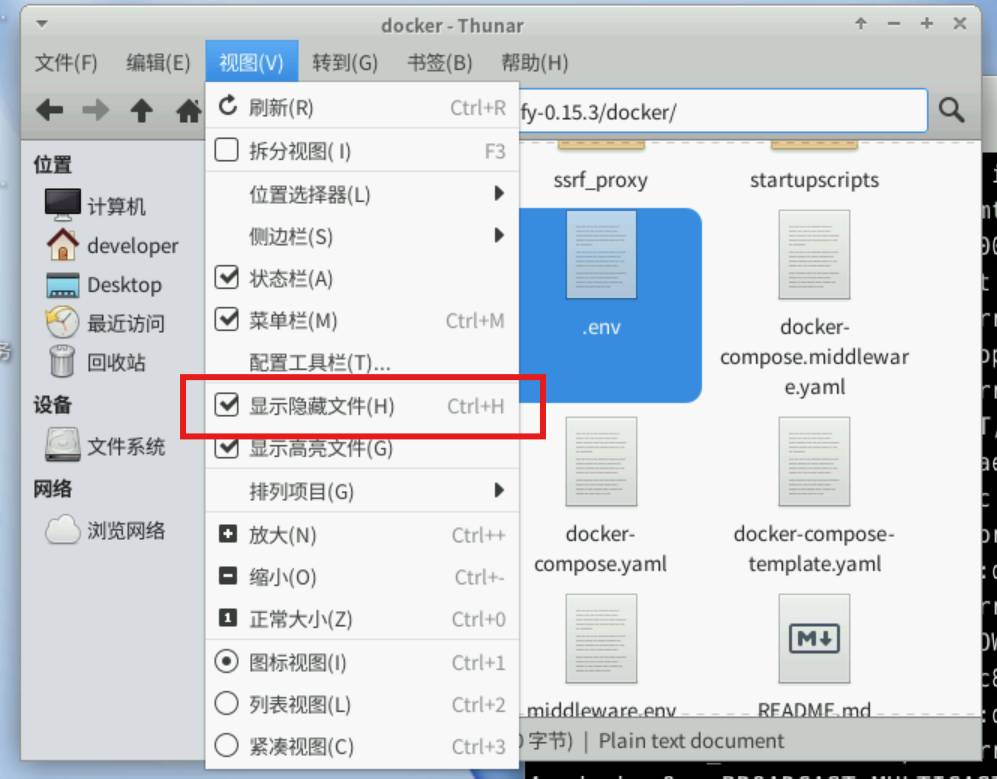

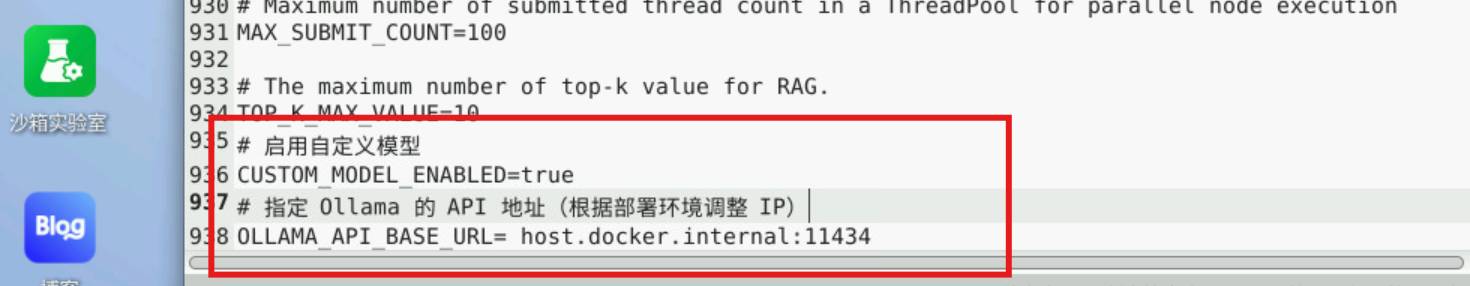

1.进入目录dify-0.15.3/docker/并修改.env没有此文件打开文件设置解除隐藏文件

2.在文件最后两行添加(参考官方开发文档)

# 启用自定义模型

CUSTOM_MODEL_ENABLED=true

# 指定 Ollama 的 API 地址(根据部署环境调整 IP)

OLLAMA_API_BASE_URL= host.docker.internal:11434

若 Dify 为 Docker 部署,建议填写局域网 IP 地址,例如:http://192.168.1.100:11434 或 Docker 容器的内部 IP 地址,例如:http://host.docker.internal:11434。

若为本地源码部署,可填写 http://localhost:11434。

查询ip地址找到自己服务器的enp3s,里的inet 后面的IP地址。

1.模型名称

docker exec -it 8a55 ollama list

ip addr

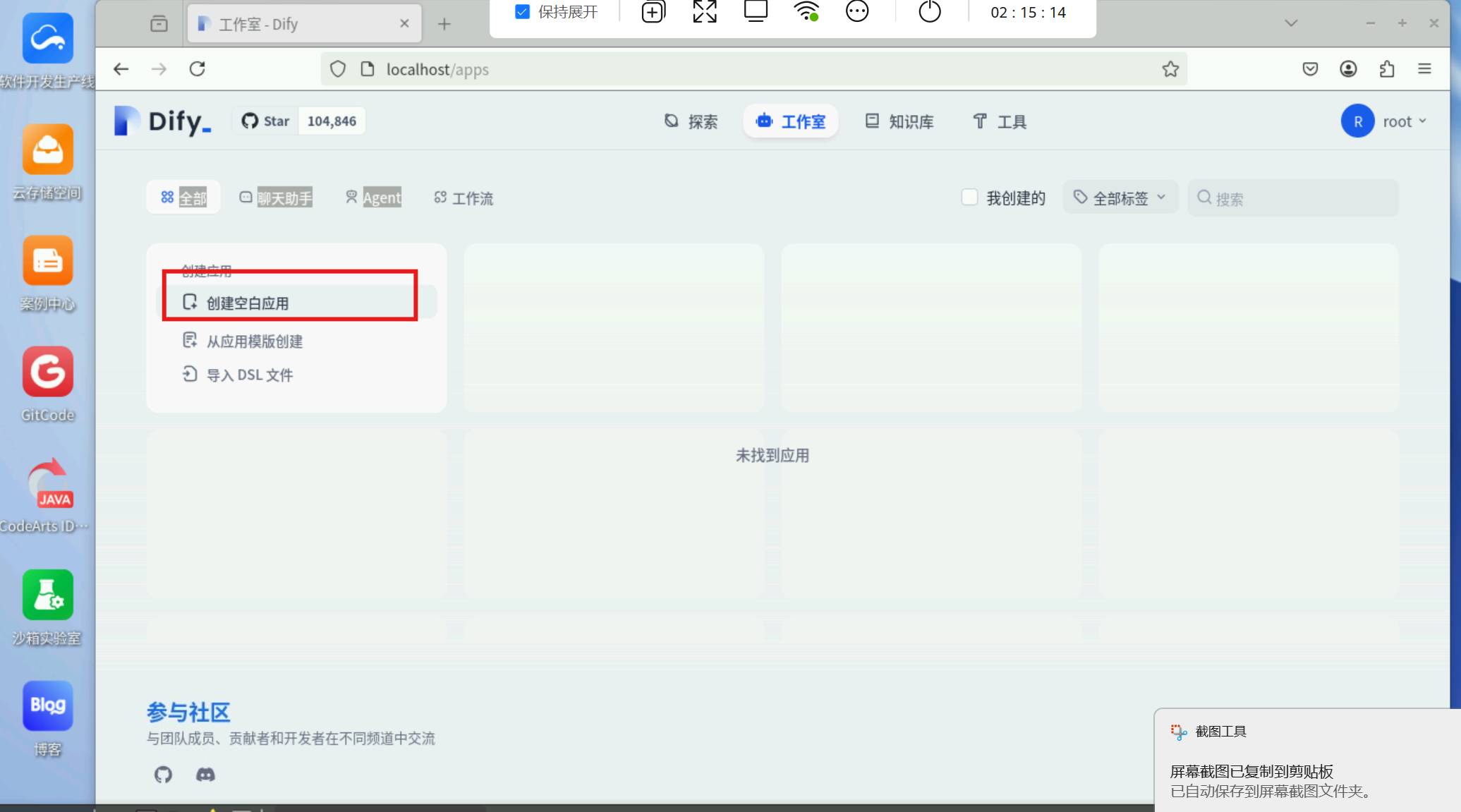

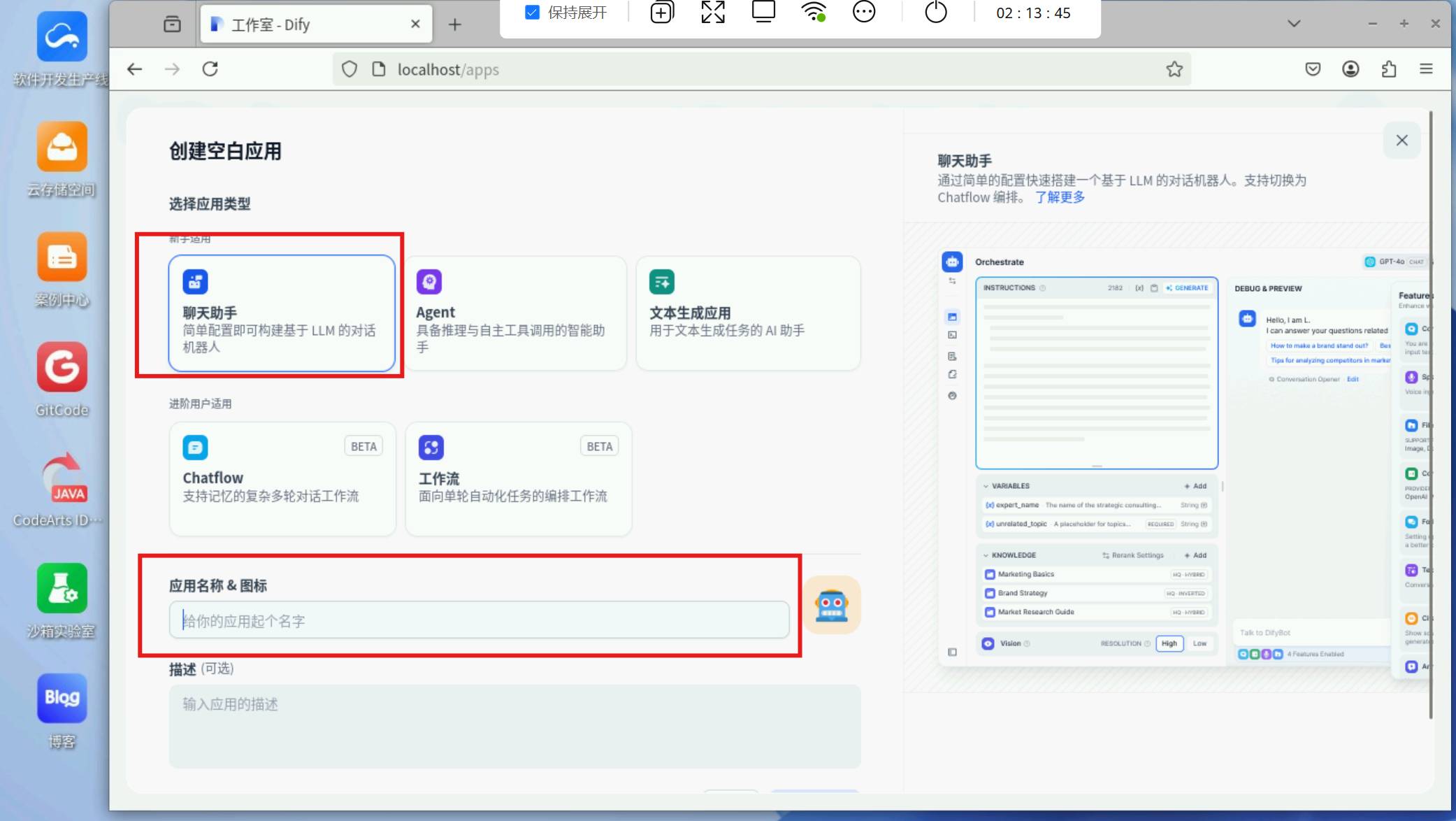

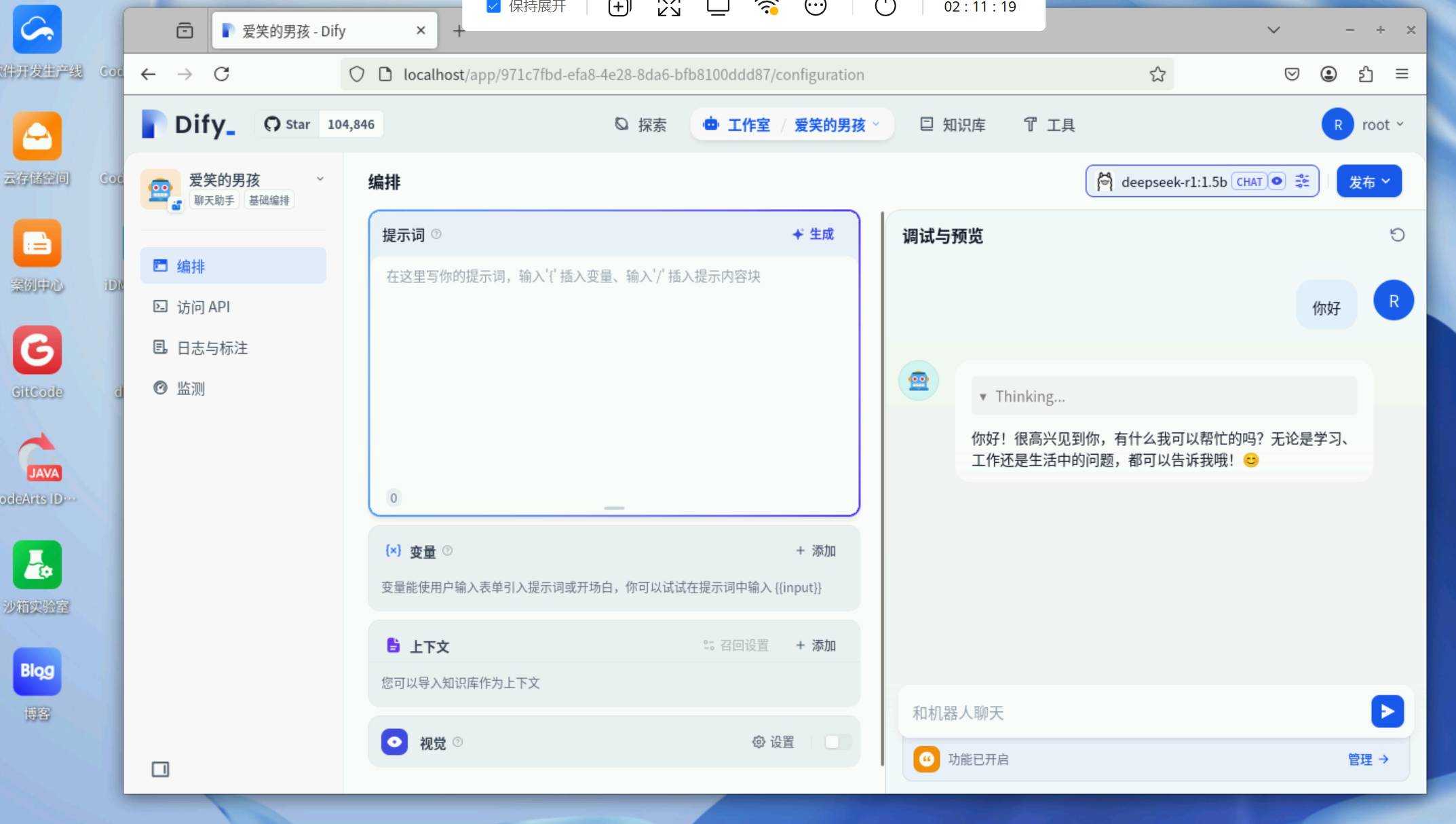

1.工作室创建空白应用

2.选择聊天助理应用名称随便起

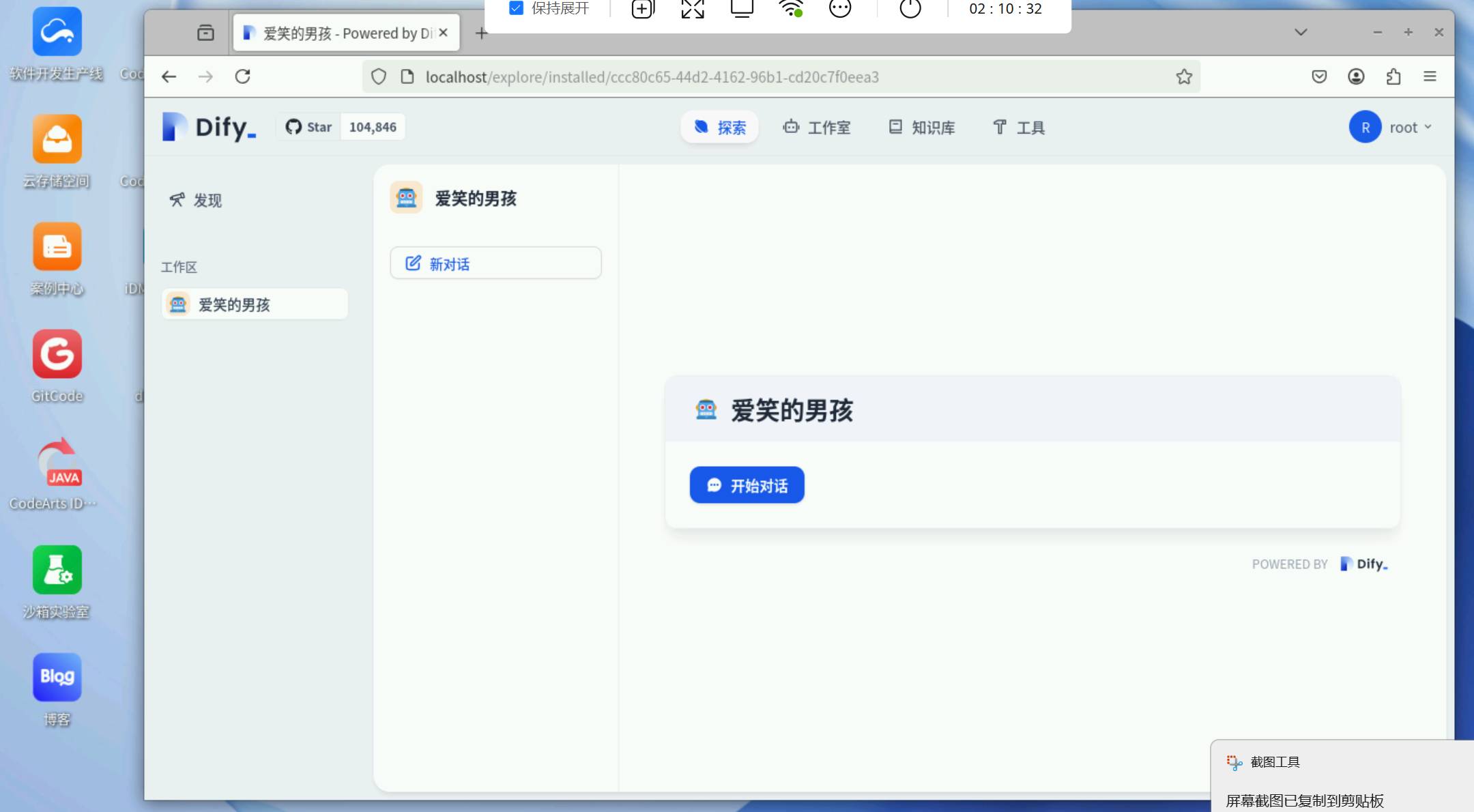

3.调试完成后发布Dify智能助手搭建完成。

开发者空间官网

开发者空间活动专题

版权说明:如非注明,本站文章均为 扬州驻场服务-网络设备调试-监控维修-南京泽同信息科技有限公司 原创,转载请注明出处和附带本文链接。

请在这里放置你的在线分享代码